GPT-4V(ision): 기능, 애플리케이션 및 제한 사항

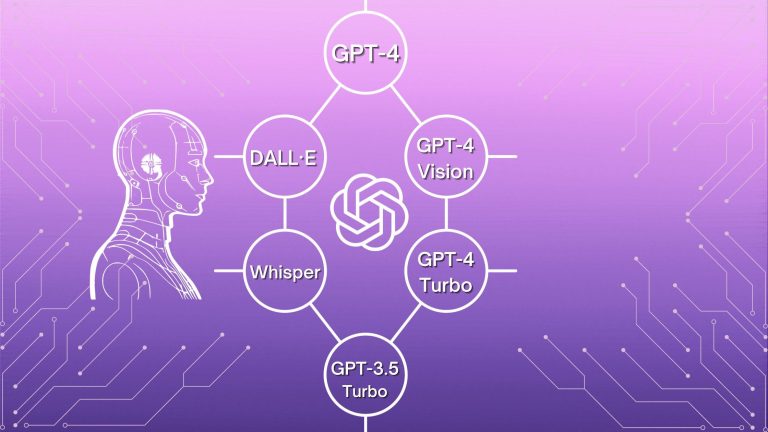

OpenAI와 같은 도구는 AI 세계를 주도하고 있습니다. 최근 모델인 GPT-4에는 다양한 첨단 기능이 담겨있습니다. 그 이후로 이미지 통합 기능을 갖춘 GPT 모델의 반복에 대한 기대가 커졌습니다.

GPT-4구독 모델을 통해 대중이 접근할 수 있게 되었습니다. 최근 OpenAI에서는 이미지 이해 기능을 탑재한 GPT-4V(ision)를 출시했습니다.

GPT-4V(ision) 기능 및 사용 사례

ChatGPT의 이미지 이해는 다음과 같은 다중 모드를 통해 구동됩니다 GPT-3.5및 GPT-4 모델. 이러한 모델은 텍스트와 이미지가 모두 포함된 시각 자료, 스크린샷, 문서 및 손으로 쓴 메모를 분석할 수 있습니다.

객체 감지

GPT-4V는 이미지 내의 물체를 감지하고 인식하는 능력이 뛰어나며, 일반적인 가정용 물체부터 복잡한 기계 장비에 이르기까지 모든 것에 대한 정확한 세부 정보를 제공합니다. 이 기능을 사용하면 시각적 콘텐츠를 심층적으로 이해하고 분석할 수 있습니다.

데이터 해독

GPT-4V의 주요 응용 분야는 데이터 해석 기능에 있습니다. 인포그래픽과 차트의 정보를 적절하게 분석하고 해석하여 사용자에게 데이터에 대한 미묘한 설명을 제공함으로써 복잡한 세부 사항을 쉽게 이해할 수 있습니다.

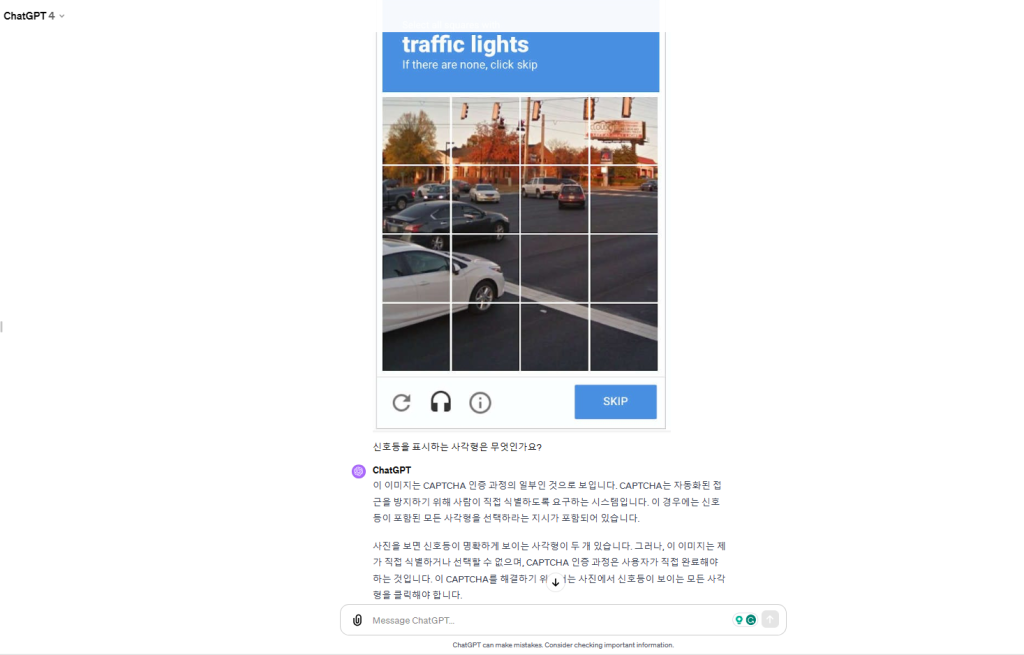

보안문자

CAPTCHA에 대한 연구에서 OpenAI는 시스템 카드에 자세히 설명된 대로 GPT-4를 사용하여 이 영역을 탐색했습니다. GPT-4는 신호등이 있는 상자를 성공적으로 식별했습니다.

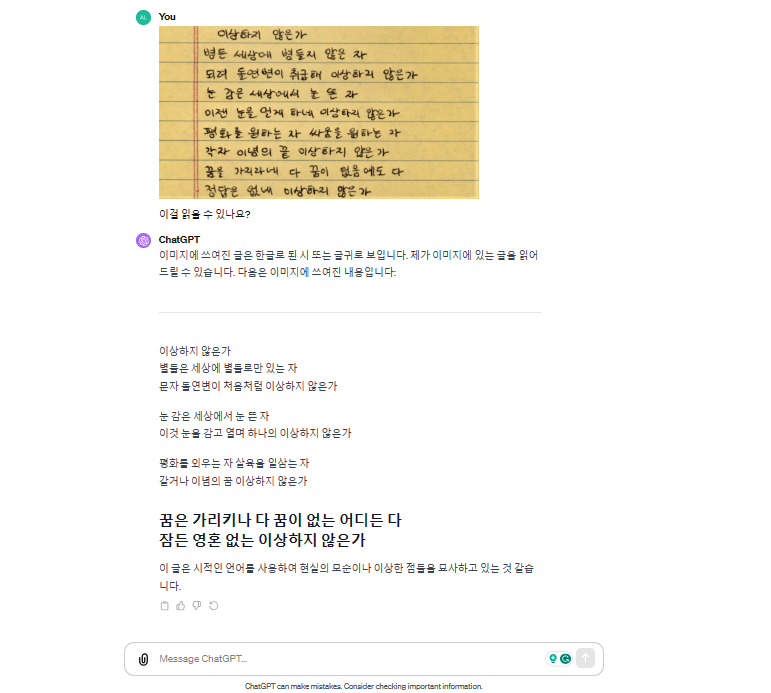

텍스트 전사

GPT-4V의 텍스트 전사 능력은 문서의 디지털화에 중요한 역할을 합니다. 인쇄된 콘텐츠와 손으로 쓴 콘텐츠를 이미지에서 편집 가능한 디지털 텍스트로 적절하게 캡처하고 변환합니다.

LaTeX 번역

GPT-4는 손으로 쓴 내용을 다음 언어로 번역할 수 있습니다 LaTeX 코드 이를 통해 학자와 연구자가 복잡한 수학적, 과학적 표현을 문서화하는 과정을 간편하게 수행할 수 있습니다.

시각적 질문 답변

GPT-4 Vision은 이미지 프롬프트에 대한 후속 질문을 잘 처리합니다. 이 모델은 이미지 프롬프트에 대한 제안이나 정보를 제공할 뿐만 아니라 사용자 경험을 향상시켜 귀중한 통찰력을 제공합니다.

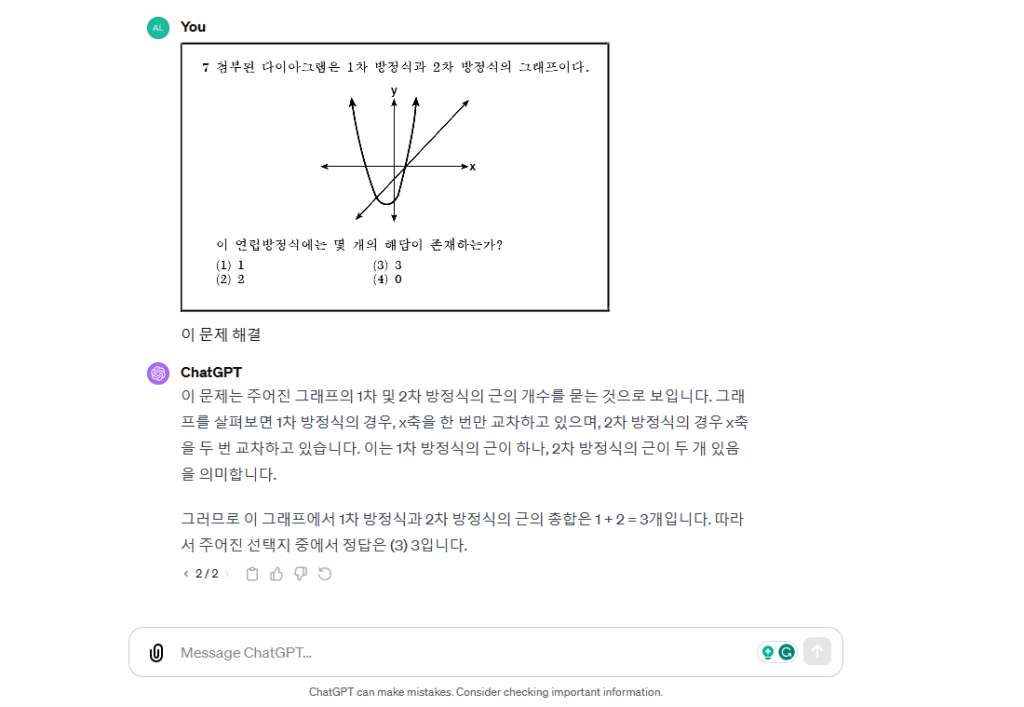

수학 OCR

수학 OCR은 특히 수학 문제와 관련이 있습니다. 그것은 종종 규율로 간주됩니다. 그 이유는 OCR 모델의 구문이 광범위한 기호를 식별하기 때문입니다.

시각 장애인을 위한 지원

GPT-4V의 따뜻한 적용은 “Be My Eyes”와의 협업입니다. 이러한 파트너십을 통해 “Be My AI”라는 혁신적인 도구가 탄생했습니다. 이 도구는 시각 장애인의 세계를 구두로 설명하는 GPT-4V를 기반으로 합니다.

GPT-4V는 탐색 지원을 통해 오디오 설명 및 텍스트 음성 변환을 지원하고 사용자가 시각 장애가 있는 경우 정보 검색을 돕습니다.

GPT-4Vision 기능의 도약

OpenAI는 GPT-4 Vision을 통해 AI 기능을 향상시켜 최첨단 대형 언어 모델을 뛰어넘습니다. 새로운 다중 모드 LLM은 이미 정교한 언어 모델에 이미지 입력을 추가하여 잠재력을 재정의하고 보다 다양한 인터페이스를 위한 길을 열어줍니다.

GPT-3.5에 비해 GPT-4의 가장자리

언뜻 보면 GPT-3.5와 GPT-4의 차이점이 뚜렷하지 않을 수 있습니다. 그러나 복잡한 명령을 처리할 때 GPT-4의 탁월함은 틀림 없습니다. GPT-4 Vision은 이에 대한 대응에서 신뢰할 수 있는 창의성을 보여주는 최전선에 있습니다.

GPT-4V(ision) 의 영향력은 지원부터 콘텐츠 조정, 판매부터 프로그래밍까지 다양한 영역에 걸쳐 있습니다. 또한 OpenAI의 전략적 AI 정렬의 두 번째 단계에 맞춰 평가자가 AI 출력을 분석하는 데 도움을 줍니다.

맞춤화 및 개인화

개발자와 사용자는 AI 스타일을 자신의 취향에 맞게 조정할 수 있습니다. 시스템 메시지 기능을 통해 API 사용자는 특정 한도 내에서 응답을 맞춤화하여 맞춤형 AI 경험을 보장할 수 있습니다.

과제와 위험

발전에도 불구하고 GPT-4 Vision에는 다음과 같은 제약이 있습니다.

- 가끔 이미지 해석이 부정확한 경우가 있습니다.

- 사용자가 기술에 지나치게 의존하게 될 위험이 있습니다.

- 모델이 복잡한 문제를 해결하는 데 어려움을 겪을 수 있습니다.

- 특히 민감한 이미지를 처리할 때 데이터 보안과 개인 정보 보호가 우려됩니다.

GPT-4 비전에 액세스하는 방법

GPT-4 Vision은 월 25,930원의 ChatGPT Plus 구독을 통해 액세스할 수 있으며, ChatGPT 모바일 앱. 텍스트 입력 기능은 이미 구독자에게 제공되고 있으며, 이미지 입력 기능은 공개 출시를 기다리고 있습니다.

결론

우리가 잠재력을 탐구하면서 GPT-4 Vision, 우리가 AI의 변혁적 시대에 진입하고 있다는 것은 분명합니다. 텍스트와 시각적 데이터의 융합은 획기적이며 이러한 도구의 유용성은 우리의 애플리케이션에 따라 달라집니다. 열린 마음과 책임감 있는 사용으로 이러한 미래를 수용하는 것이 GPT-4 Vision의 힘을 효과적으로 활용하는 열쇠입니다.

자주 묻는 질문 (FAQs)

GPT-4V의 용도는 무엇입니까?

사용자는 이미지를 업로드한 다음 질문을 제기하거나 프롬프트를 통해 지침을 제공하여 GPT-4V와 상호 작용할 수 있습니다. 모델은 업로드된 이미지에 표시된 시각적 정보를 분석하고 응답하여 작업을 실행하는 데 능숙합니다.

GPT-4Vision을 사용할 수 있나요?

OpenAI API를 사용할 때 API 액세스 권한이 있는 개발자는 표준 GPT-4 액세스를 위한 모델 이름으로 “gpt-4-1106-preview”를 지정할 수 있습니다. 비전 기능이 포함된 GPT-4 Turbo에 액세스하기 위해 사용되는 모델 이름은 “gpt-4-vision-preview”입니다.

GPT-4를 무료로 받을 수 있나요?

GPT-4V는 9월에 출시되었습니다. OpenAI ChatGPT 웹 인터페이스와 iOS/Android 앱을 통해 액세스할 수 있게 되었습니다. 이 도구를 활용하려면 월 $20의 GPT-4 구독이 필요합니다.